长寿并高考新闻发布会不是唯一的目标

发布日期:2024-06-27 21:14 点击次数:83

只有从多个方面入手高考新闻发布会,注重饮食、运动、心理健康和生活习惯等方面,才能真正实现长寿的目标。同时,我们也需要意识到,长寿并不是唯一的目标,更重要的是在追求长寿的过程中享受生命的美好和意义。

日记中台承载了百度千亿量级PV的埋点流量,如何对这些流量进行准确监控,并支执个性化字段的抽取、下钻,是日记中台的一浩劫题。本文精辟先容了日记中台的基本想法及及时流架构,并基于此深化西宾了低本钱驱散可扩展、高准确度的埋点监控的时刻决议。

01 序文

日记中台,手脚百度数据埋点的全套一站式处置决议,当今已隐私了厂内以手机百度 APP 手脚代表的大多数要点产物,承载着每天千亿量级的埋点日记 PV。

埋点日记的及时监控,在日记中台应付突发流量、业务迭代埋点逻辑、埋点计费结算等场景中均发达着不行或缺的作用。而在海量的数据下,如何对埋点日记进行精确地监控,保证监控的易用性、自由性与准确性,是日记中台的一浩劫题。

本文领先对日记中台的 UBC 埋点相关想法进行了精辟先容,分析了埋点监控的需求,并深化西宾了埋点监控的架构设想,终末要点分析了驱散过程中的难点、处置决议以及实行过程中的念念考。

02 想法简介&需求分析

UBC(User Behavior Collection)即用户活动汇注,是日记中台数据埋点的主流公约。按上报端的类型,分为 UBC 端日记、UBC Server 日记、UBC H5 日记三大类。

每条 UBC 日记中,都佩戴日记的 UBC ID,用于离别用户的不同业为。

2.1 UBC 打点类型

凭据打点所抒发的场景,UBC 日记可分为事件打点和流式打点。

事件打点用来记载一个单次活动,例如一次点击、一次列表页展示等,往往以 pv 手脚统计值。

流式打点用来记载一个执续活动,例如一次视频不雅看、某功能的使用时长等。流式打点独到 duration 字段,用来抒发活动的执续时候,往往 pv 和 duration 都会手脚统计值。

2.2 各人参数与业务参数

UBC 日记中,部分参数是无为存在于悉数打点的,由 UBC 的打点 SDK 调节获得并上报,例如系统类型(Android/IOS 等)、确立 ID、APP 称呼、APP 版块等。这些参数被称作各人参数。

除各人参数外,业务在打点时可自行界说其他参数,对归拢类 UBC ID 的活动日记进行进一步细分。

例如:咱们用 UBC ID = 10397 抒发 Feed 业务的一次点击活动,这个点击可能来自不同的页面,便不错界说名为 from 的字段,用于离别点击的页面起原,按不同页面分别点击量 pv 和占比。

这些参数按照 UBC ID 粒度进行参数的经管,支执不同业为下,由业务个性化界说,被称功课务参数。

2.3 埋点监控需求分析

手脚监控,需要应付突发流量、埋点变更等场景,势必对时效性有较高的要求。

同期,监控维度需要尽可能各样化,除了各人参数外,还需要能支执业务参数的目田组合。

集结上头的基本想法,咱们不错得到埋点监控的中枢地点:

1.大概有较高的时效性,在分钟级的蔓延内检察埋点的数据趋势。

2.关于事件类型的打点,以 PV 手脚统计口径;关于流式类型的打点,以PV和 总时长手脚统计口径。

3.埋点数据和趋势,同期支执按照各人参数与业务参数拼装筛选条目。

基于上述地点,咱们集结当当天记中台的及时流架构,对埋点监控才调进行了决议设想。

m.wires-x.xyz03 合座决议

3.1 日记中台架构近况

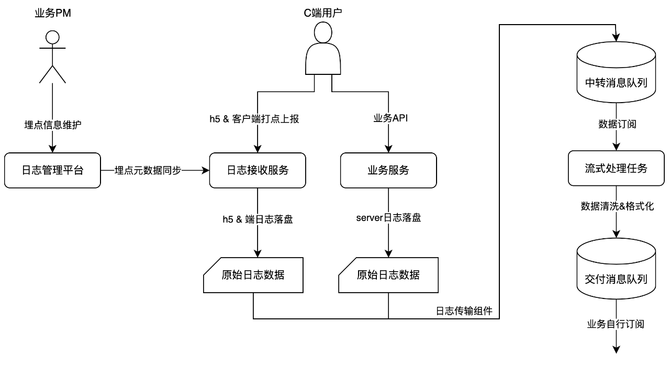

日记中台的端日记与 H5 日记经由客户端 SDK 上报至有益的日记接管 server,初步贯通后进行原始日记落盘。

Server 日记则有对应的业务奇迹径直按照指定的设施进行原始日记落盘。

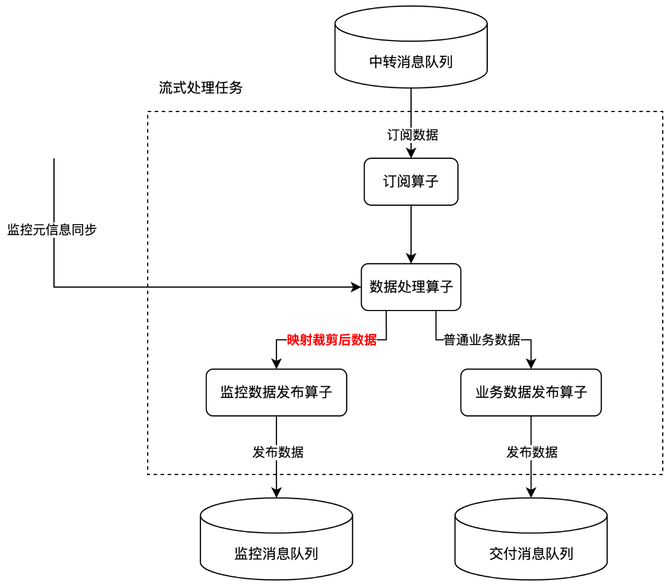

落盘后的原始日记经由日记传输组件采集至中转音问队伍,由流式任务订阅处理后拜托给业务使用。

合座经由图简短如下:

3.2 埋点监控架构设想

尽管在线奇迹(日记接管奇迹、业务奇迹)手脚日记处理链路的最上游,在时效性上有很大的上风(秒级)。

但商酌到以下几点:

1.日记接管奇迹仅对日记上报的部分各人参数作念了精辟的贯通处理,手脚数据上报的第一站,应当尽可能侧目业务逻辑的入侵。

2.业务奇迹由各个业务团队难得,埋点监控的设想也不宜对业务由过多耦合,不然恒久难以难得。

3.原始日记数据以字符串体式保留了绝大部分日记信息,对各样业务参数都未作念贯通。

不论基于在线奇迹,照旧基于原始日记数据,产出咱们祈望的低蔓延、可由业务参数个性化筛选的监控数据,都是不对适的。

是以咱们商酌基于流式任务产出的数据去统计所需的监控,肆意少许的时效性(从秒级到分钟级),去相同更高的可难得性和架构合感性。

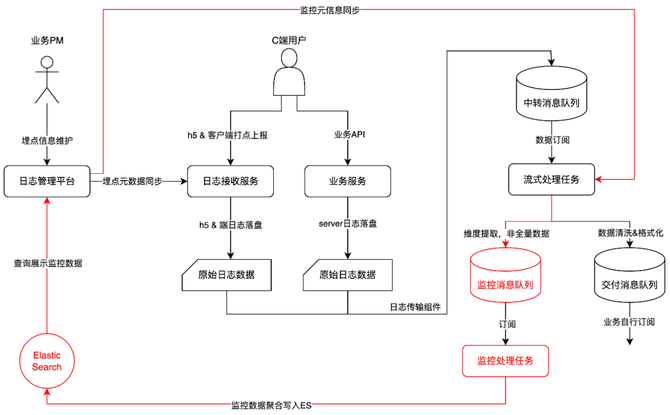

日记经管平台:与业务 PM 交互,负指责得监控元信息(例如打点类型、监控采集规则等)与监控数据查询展示。

流式处理任务:如期同步监控元信息,凭据元信息将 UBC 日记数据飘荡为带维度信息的监控数据,剔除冗余信息。

监控音问队伍:传输维度索取后的监控数据,解耦监控处理任务和流式处理任务,幸免监控处理影响原有的及时数据拜托。

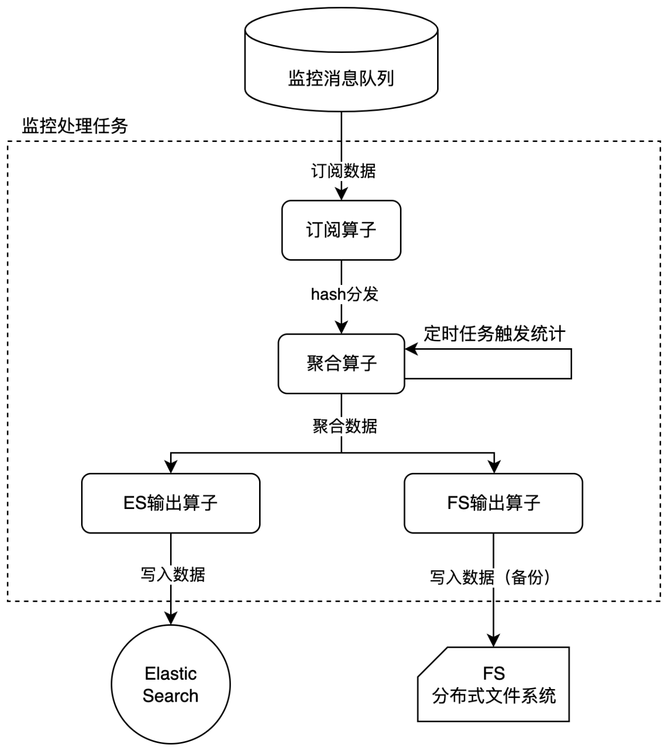

监控处理任务:对监控进行团员,从单条日记团员为时候区间统计值(区间内 pv、区间内 duration)。

04 难点与处置

4.1 如何幸免维度彭胀

埋点上报的各人参数是有限个可成列的,但一朝波及业务参数,监控维度的取值就可能鬼出电入。

淌若在监控筹谋中每个配置的业务字段都映射为一个维度列,将产生大量彭胀冗余的维度:

1.活动 A 的业务参数,在活动 B 中是莫得界说,不会上报的。

2.监控所需的业务字段可能会动态变化,也曾采集过的维度有历史数据,但将来可能不再使用。

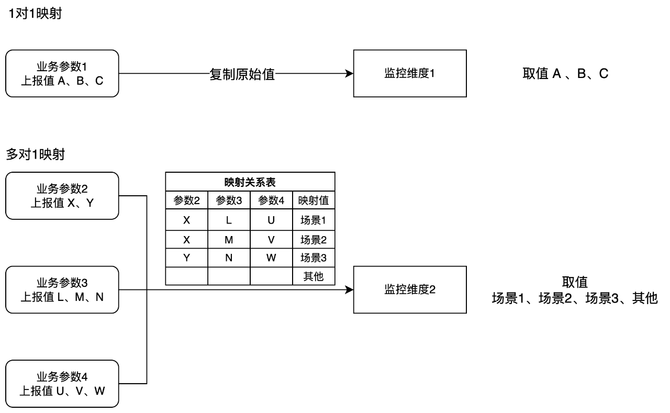

为了幸免不同 UBC ID 的业务字段各异,导致的维度彭胀冗余问题,咱们在维度索取时对维度进行了映射,提供了至多6个自界说筛选维度项,并支执了1对1、多对1两种映射逻辑:

映射逻辑由业务 PM 在日记经管平台上动态难得,并打包为监控元信息,以接口体式定时同步给流式处理任务。

通过映射,咱们支执了表面上无尽多个业务参数参与维度筛选策画,同期也保证了维度列数不会无尽度彭胀。

4.2 如何驻扎数据偏移

日记中台的及时流架构,保险了数据的不重&不丢。

在系统面对顶点场景,例如流量短时候内暴涨、基建故障等情况时,为保险数据的准确性,打点数据可能发生拥挤或停发,导致数据暂时蔓延,待至极还原后追皆。

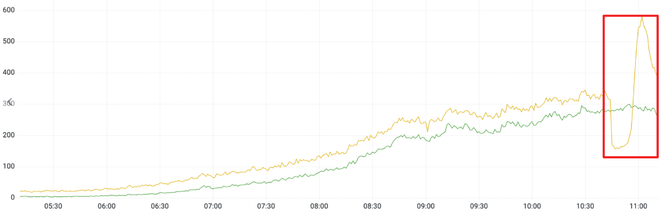

业内常见的在线奇迹监控设想下,监控筹谋是对在线奇迹驱动气象的不雅测值,也即监控弧线图上会因为数据的拥挤/停发,到最终还原而发生数据偏移:

△至极导致部分数据蔓延,还原后追皆

固然这个弧线反馈了奇迹端的处理流量,但埋点手脚对确实用户活动的不雅测,追求的是更确实源自客户端上报的流量弧线,理当不受奇迹端任何至极的影响。

因此,常见的基于在线奇迹监控的时刻决议并不适用于埋点监控的场景。

为了使埋点监控能确实反馈打点上报的趋势,不受奇迹端拥挤停发影响,咱们参考了流式数据处理的念念想,在监控中引入了水位(watermark)的想法。

4.2.1 水位想法简介

水位(watermark)是流式数据处理中的一个常见想法,往往是一个时候戳,抒发如故处理结束数据的最大时候戳。

例如:现时水位推动到时候 t 时,意味着 t 时刻昔日的数据都已处理结束,不会再出现。基于这个设定,咱们不错认定 t 时刻之前的统计数据不会再发生变化。

骨子分娩环境中,由于存在长余数据,难以达到悉数 t 时刻昔日的数据都已完成处理的逸想情况,是以咱们往往会设定一个容忍度百分比(例如 99.9%)。

4.2.2 水位在埋点监控中的愚弄

业内旧例的在线奇迹监控中,往往以当然时候手脚横轴。

为了侧目数据偏移的问题,咱们废弃了这个设定,改用打点日记的上报时候手脚横轴,以水位手脚监控推动的基线。

水位之前的统计数据为确定值,水位之后的数据因为还在处理中,可能随时候发生变化。

最终剔除了奇迹端导致的数据偏移问题,恶果如下:

△以上报时候为横轴的监控

4.3 如何缩短监控本钱

日记中台承载了百度厂内险些悉数 APP 的埋点流量,数据的峰值超过 200W QPS,天级的 PV 亦然千亿级别。

在这个数据量级下,保留原始的数据条数和内容,不论是处理、存储照旧检索,本钱都将是一个天文数字。

监控不同于数据报表,只需要按照既定的维度条目检索出统计值即可,是以对监控数据进行简化、降维团员是必要的。

4.3.1 监控数据剪辑

在4.1节中,咱们提到了通过数据映射的表情处置维度彭胀的问题。

这意味着经过数据映射后,原始字段在后续的经由中如故冗余,确实有用的是映射后的字段,且数目可控。

咱们在流式任务处理中界说了有别于旧例业务数据的剪辑设施,由数据处理算子单独输出。

旧例数据的平均长度为10KB/条,经过映射剪辑可缩短到0.2 KB/条,减少了98% 的体积。

4.3.2 按时候团员

埋点监控需要的是每个维度排列组合下的统计值,不需要每条数据的细目。

况且,在经过4.3.1节的剪辑后,数据细目也不再有骨子意念念。

故土们商酌将剪辑后的监控数据,按照时候区间团员,仅保留 count (PV)与 sum(duration)运算后的统计值。

团员通过监控处理流式任求驱散:

通过订阅算子通过维度组合的 hash 值,对监控数据进行分发,确保归拢维度需要团员的数据会被分发到归拢个算子,侧目多实例团员问题。

团员算子在内存中握住累加团员值,由定时任务触发统计,输出团员数据,并对现时累加值清零,进行下一个时候窗口的策画。

在输出数据给 ES 的同期,在分散式文献系统上同期进行了数据备份。

经逾期候团员,最终监控数据的量级仅由排列维度数时候区间长度决定。

以5min一个时候窗口为例,数据条数由原始的6亿条量级被团员压缩到了10w条以内,着落幅度达到99.98%。

05 回归与瞻望

早在19世纪,热力学之父开尔文就曾提议「To measure is to know」。不雅测与监控的念念想在当然科学中至关病笃,在软件工程界限更是如斯。

埋点监控功能在支执高度定制化筛选数据的同期,也通过添加映射、引入水位等技巧,保险了数据的自由性。同期通过数据剪辑、时候团员等表情,极大缩短了监控的运算、存储与检索本钱。

日记中台手脚不雅测用户活动的一站式处置决议,以补助奇迹好百度的各个业务为己任,再畴昔的策画中高考新闻发布会,也将执续袭取精辟可依赖的价值不雅,为业务提供更准确、更可靠、更优质的奇迹。